Dal 1965 la legge di Moore è stata motivo di entusiasmo per tecnici ed appassionati di informatica, fino al giorno in cui la SIA, società americana che raggruppa i principali produttori di microprocessori ed aziende connesse al business del silicio, decide che da adesso in poi tale legge non sarà più sostenibile. La storia inizia 51 anni fa, quando il cofondatore di Intel Gordon Moore notò che era possibile organizzare il processo produttivo dei microprocessori in modo tale da portare sul mercato modelli la cui potenza di calcolo raddoppiasse ogni quanto di tempo. Inizialmente questo lasso di tempo era fissato a dieci anni, ma poi si notò che era possibile conseguire lo stesso risultato in soli due anni.

Dal 1965 la legge di Moore è stata motivo di entusiasmo per tecnici ed appassionati di informatica, fino al giorno in cui la SIA, società americana che raggruppa i principali produttori di microprocessori ed aziende connesse al business del silicio, decide che da adesso in poi tale legge non sarà più sostenibile. La storia inizia 51 anni fa, quando il cofondatore di Intel Gordon Moore notò che era possibile organizzare il processo produttivo dei microprocessori in modo tale da portare sul mercato modelli la cui potenza di calcolo raddoppiasse ogni quanto di tempo. Inizialmente questo lasso di tempo era fissato a dieci anni, ma poi si notò che era possibile conseguire lo stesso risultato in soli due anni.

L'industria dei microprocessori era ben consapevole fin da allora che esisteva un limite alla miniaturizzazione, eppure il costante aumento del numero di transistor all'interno delle unità logiche ci ha accompagnati nell'euforia degli anni '90 e per buona parte del decennio precedente. Già dai primi del 2000, scendendo al di sotto della soglia dei 90 nm, si iniziarono a riscontrare delle difficoltà oggettive dovute alla dissipazione di calore dei componenti.

Negli anni '90 aquistare hardware era quasi deprimente. Spendendo alcuni milioni di lire ci si portava a casa l'ultimo grido in fatto di tecnologia, ma si restava sulla cresta dell'onda per soli sei mesi, nove al massimo. La frequenza di clock dei microprocessori aumentava significativamente ma ad un ritmo pianificato, per sostenere un consumo di massa che in quegli anni aveva visto un vero boom senza però bruciare le tappe. Il primo processore Pentium vede la luce nel 1993 e va a rimpiazzare il caro e vecchio Intel 80486, senza aggiungere di fatto grandi novità se non l'introduzione della pipeline nell'esecuzione delle istruzioni. Tale funzionalità rendeva i processori Pentium quasi due volte più veloci rispetto ai modelli basati su architettura i486. Da qui inizia una lunga corsa la rialzo.

Negli anni '90 aquistare hardware era quasi deprimente. Spendendo alcuni milioni di lire ci si portava a casa l'ultimo grido in fatto di tecnologia, ma si restava sulla cresta dell'onda per soli sei mesi, nove al massimo. La frequenza di clock dei microprocessori aumentava significativamente ma ad un ritmo pianificato, per sostenere un consumo di massa che in quegli anni aveva visto un vero boom senza però bruciare le tappe. Il primo processore Pentium vede la luce nel 1993 e va a rimpiazzare il caro e vecchio Intel 80486, senza aggiungere di fatto grandi novità se non l'introduzione della pipeline nell'esecuzione delle istruzioni. Tale funzionalità rendeva i processori Pentium quasi due volte più veloci rispetto ai modelli basati su architettura i486. Da qui inizia una lunga corsa la rialzo.

Nel 1996 si passa dal Pentium 133Mhz al modello successivo a 166Mhz, per poi fare spazio alla tecnologia MMX e le sue microistruzioni multimediali, le SIMD, al livello assembler. In effetti c'era un gran bisogno di multimedialità e portare tali funzioni a livello di microprogrammazione era sicuramente un vantaggio per gli sviluppatori di software, ma non per i progettisti hardware, che si vedevano man mano appesantire l'architettura del microprocessore e rallentato il ciclo di fetch-decode-execute tanto efficiente nelle vecchie architetture RISC.

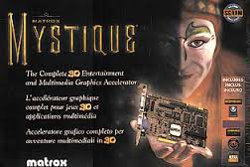

In quegli anni iniziarono a vedersi anche le prima schede video accelerate e 3Dfx. Questo perché si era compreso che, demandando a dispositivi dedicati le funzionalità grafiche, si poteva scaricare di lavoro il processore, aumentando di fatto le prestazioni senza apportare innovazioni architetturali all'interno della CPU. Nella seconda metà degli anni '90 nascono tantissime nuove tecnologie mirate a soddisfare le esigenze di un mercato che stava crescendo a dismisura: quello dei videogiochi.

In quegli anni iniziarono a vedersi anche le prima schede video accelerate e 3Dfx. Questo perché si era compreso che, demandando a dispositivi dedicati le funzionalità grafiche, si poteva scaricare di lavoro il processore, aumentando di fatto le prestazioni senza apportare innovazioni architetturali all'interno della CPU. Nella seconda metà degli anni '90 nascono tantissime nuove tecnologie mirate a soddisfare le esigenze di un mercato che stava crescendo a dismisura: quello dei videogiochi.

Il processo non era ancora finito, perché parallelamente di stava evolvendo il processore Pentium Pro, destinato a sparire di lì a poco con l'avvento del Pentium II nel 1997. Tutti ricordiamo il processore Pentium Pro perché si poteva operare l'overclock e spingere il processore a lavorare a frequenze più alte, a costo di una maggiore dissipazione di calore.

Di lì in poi si susseguirono Pentium III, Pentium IV e Pentium D, per poi sbarcare all'architettua Intel Core 2. Fu probabilmente da questo momento che si iniziano a riscontrare difficoltà crescenti per sostenere il passo con la legge di Moore, infatti si iniziò a puntare sempre di più sul parallelismo. Questa nuova necessità era soprattutto dettata dal fatto che l'utenza si era allargata parecchio e la stragrande maggiornanza usava il computer per compiti di ufficio con richieste di calcolo limitale. La cosa più importante era avere interfacce grafiche sofisticate ma che rispondessero in maniera rapida all'utente e la capacità di gestire in modo efficiente l'input-output di più applicazioni contemporaneamente.

La necessità di connettività a banda larga ha poi spostato il grosso delle attività di calcolo nei datacentre delle grandi compagnie ed infine la rivoluzione mobile ha spinto sempre più i produttori di hardware a elargire potenza di calcolo con parsimonia.

La necessità di connettività a banda larga ha poi spostato il grosso delle attività di calcolo nei datacentre delle grandi compagnie ed infine la rivoluzione mobile ha spinto sempre più i produttori di hardware a elargire potenza di calcolo con parsimonia.

Alla fine di questo lungo viaggio c'è da chiedersi se la legge di Moore, per quanto entusiasmante, possa davvero essere ancora utile in un periodo storico in cui i dispositivi mobile sono diventati il target e le attività CPU intensive sono sempre più centralizzate. Infine, non conoscendo una valida alternativa al silicio per produrre una nuova generazione di dispositivi, visto l'immane costo per lo sviluppo di nuove tecnologie che per ora esistono solo a livello teorico e le relative linee di produzione, vista la frammentazione del mercato ed la conseguente difficoltà nell'ottenere un ritorno di investimento in questo settore, sembra che ci si dovrà accontentare.